ChatGPT von OpenAI hat sich in kürzester Zeit einen Namen in der Tech-Welt gemacht. Die plattformunabhängige, nutzerfreundliche Schnittstelle hat es IT-Profis und Laien gleichermaßen ermöglicht, in die Welt der Large Language Models (LLMs) einzutauchen.

Laut einer Umfrage von Bitkom werden in den nächsten Jahren 74% der 605 Befragten Unternehmen in Künstliche Intelligenz investieren[1]. Generative KI bietet neue und bahnbrechende Möglichkeiten zur Umsatzsteigerung, Kostensenkung, Produktivitätssteigerung und zum besseren Risikomanagement. In naher Zukunft wird sie zu einem Wettbewerbsvorteil und Differenzierungsmerkmal werden.

In einer kürzlich von Gartner[2] durchgeführten Webinar-Umfrage unter mehr als 2.500 Führungskräften gaben 38 % an, dass die Kundenerfahrung und -bindung das Hauptziel ihrer Investitionen in generative KI ist. Weitere Ziele sind Umsatzsteigerung, Kostenoptimierung und Geschäftskontinuität. Für Entscheider ist hier ein klarer Handlungsimpuls zu erkennen: Generative KI kann und wird als Schlüsseltechnologie in vielen Unternehmensbereichen eingesetzt. Das Spektrum reicht von der IT, wo Code automatisch generiert wird, bis hin zu Forschung & Entwicklung für datengetriebene Analysen. Selbst im Marketing, wo personalisierte Werbemaßnahmen oder Bildgenerierungen gefragt sind, zeigt sich der Einfluss der Generativen KI.

In diesem Artikel wollen wir aufzeigen, wie Sie die Potentiale von Large Language Models in der Kundeninteraktion nutzen können und welche Investitionen nötig sind, um diese bahnbrechende Technologie in Ihrem Unternehmen zu integrieren. Es ist nicht nur eine Frage des „Ob“, sondern des „Wann“. Es ist an der Zeit, sich den strategischen Vorteil der Generativen KI zunutze zu machen.

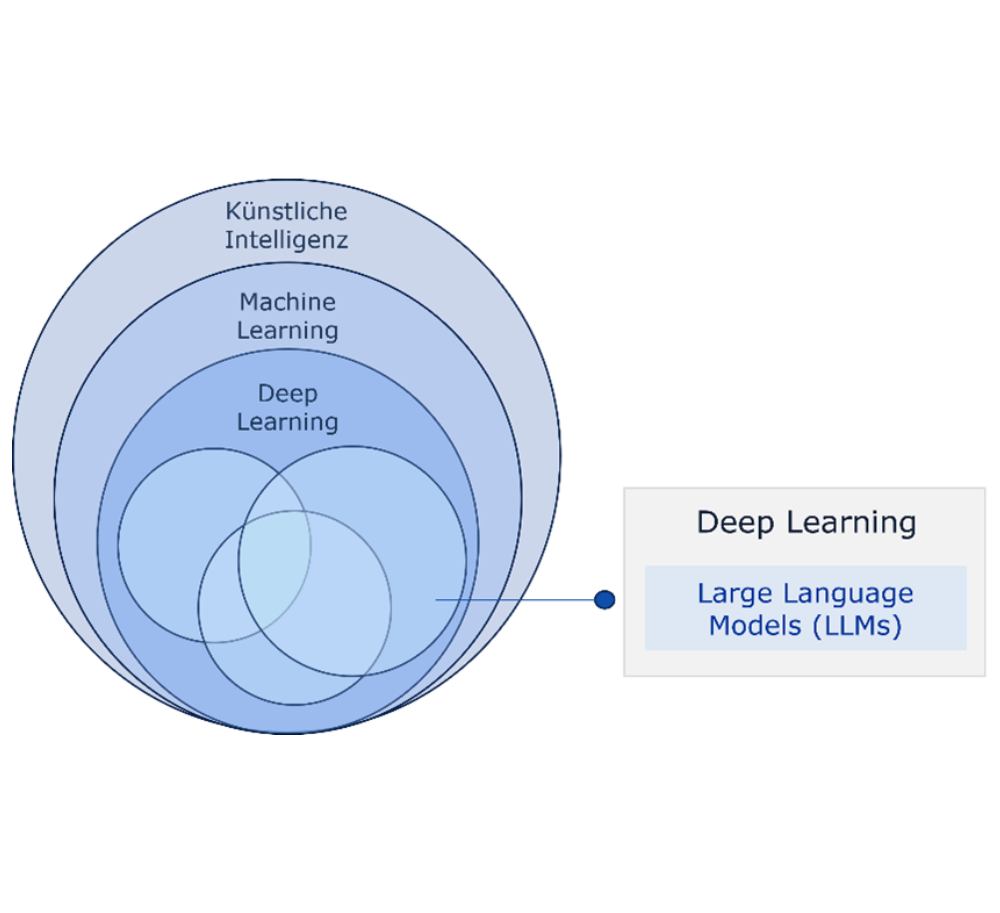

Generative KI repräsentiert die nächste Welle in der KI-Entwicklung. Wo wir einst Maschinen beibrachten, eine Katze von einem Hund zu unterscheiden, ermöglichen uns heute Generative Modelle, Inhalte von Grund auf neu zu erstellen, sei es Text, Audio oder Bilder. In der KI-Landschaft ist die Generative KI ein Subset des Deep Learning, das wiederum ein Subset des Machine Learnings ist. Insbesondere LLMs wie ChatGPT sind hierbei von großer Bedeutung. Diese Modelle können nicht nur Informationen verarbeiten, sondern auch eigene Inhalte generieren.

Im Kern nutzen Generative Modelle wie LaMDA, LLaMA oder GPT riesige Datenmengen und verwenden „Transformers“, um diese Informationen zu verarbeiten. Dabei kann es jedoch zu „Halluzinationen“ kommen – unsinnige oder falsche Aussagen des Modells. Die Gründe können vielfältig sein, wie mangelnde Daten, unsaubere Trainingssets, Overfitting oder unklare Beschränkungen.

Das Sammeln von qualitativ hochwertigen und diversifizierten Daten ist entscheidend, aber Konzepte wie z.B. „Prompt Design“ und „Grounding“ sollten ebenfalls berücksichtigt werden.

- Prompt Design: Ein guter Prompt (Eingabeaufforderung) leitet das Modell, um qualitativ hochwertige Antworten zu geben. Das bedeutet, dass die Art und Weise, wie Sie das Modell fragen, die Art der erhaltenen Antwort beeinflusst.

- Grounding: Dabei wird das Modell auf bestimmte Informationsquellen „geerdet“. Ob Faktenbasis, Dokumentenverweis oder Wissensdatenbank – Grounding sorgt dafür, dass die KI ihre Antworten auf verlässliche Daten stützt.

Abhängig von den vorliegenden Daten existieren unterschiedliche Formen der Generativen KI, die jeweils für spezielle Problemstellungen geeignete Modelltypen bereithalten. Wir konzentrieren uns vorrangig auf Ansätze, die auf der Verarbeitung natürlicher Sprache basieren. Hierbei differenzieren wir insbesondere zwischen den Modelltypen text-to-text und text-to-task. Hugging Face. bietet eine umfassende Übersicht über verschiedene Modelle in diesem Bereich.

Der Modelltyp „text-to-text“ verwendet natürliche Sprache in Textform als Input und liefert ebenfalls Text als Output. Diese Modelle werden trainiert, um die Zuordnung zwischen zwei Texten zu verstehen. Anwendungsbeispiele hierfür sind das Zusammenfassen von Informationen, Übersetzen, Extrahieren von Daten, Clustern von Inhalten, Umschreiben/Beschreiben von Inhalten, Klassifizieren von Text oder das Generieren von neuem Text.

Im Gegensatz dazu sind „text-to-task“ Modelle darauf ausgerichtet, basierend auf einer Texteingabe spezifische Aufgaben oder Aktionen auszuführen. Die Palette an möglichen Aufgaben ist breit gefächert: Von der Beantwortung von Fragen über das Durchführen von Suchanfragen bis hin zur Erstellung von Vorhersagen. Zum Beispiel könnte ein „text-to-task“ Modell darauf spezialisiert sein, bestimmte Befehle in einer Benutzeroberfläche auszuführen. Mit Hilfe dieser Modelle können Unternehmen fortschrittliche Softwareagenten, virtuelle Assistenten und weitreichende Automatisierungslösungen realisieren.

Generative KI kann, richtig angewendet, einen signifikanten Wert in der Kundenkommunikation erzeugen. Hierbei ist es essenziell, dass Kommunikationskanäle – sei es in Richtung Kunde oder intern – effizient, sicher und zuverlässig gestaltet sind. Ein gewisser Reifegrad in der Anwendung der KI ist hierbei unumgänglich. Mit dem nötigen Datenvolumen im Rücken kann die generative KI Trends und Muster identifizieren, Inhalte neu generieren, Abläufe automatisieren und so die Kundeninteraktion auf ein neues Level heben.

Softwareagenten und virtuelle Assistenten

Stellen Sie sich die generative KI als eine Art digitalen Assistenten vor, der die Interaktionen Ihrer Mitarbeiter mit Kunden verbessert und optimiert. Ein konkretes Beispiel: Nach einem Kundengespräch erstellt der KI-Assistent automatisch eine Zusammenfassung, welche im CRM-System hinterlegt wird. Bei einem erneuten Kundenkontakt können Mitarbeiter umgehend auf diese Notizen zugreifen, wodurch sie besser auf den Kunden eingehen können und keine wertvolle Zeit für die Recherche vergeuden. Darüber hinaus kann die KI systemübergreifend Daten zusammenführen und so beispielsweise relevante Informationen aus der firmeneigenen Wissensdatenbank und dem CRM-System miteinander verknüpfen, daraus resultierende Handlungsempfehlungen ableiten und sogar die geeigneten Ansprechpartner für spezifische Themen vorschlagen. Ein innovatives Praxisbeispiel bietet die Plattform „Lilli“ von McKinsey. Dieses interne Tool wird mit firmeneigenen Research-Papers gefüttert und agiert als Wissensquelle für Mitarbeiter. Gibt man eine Anfrage in das System ein, durchsucht Lilli den Datenpool und präsentiert die relevantesten Inhalte, fasst Schlüsselpunkte zusammen, liefert direkte Verlinkungen und stellt sogar Experten zu dem Thema vor. Solche Anwendungen zeigen, welches Potenzial in der Verknüpfung von generativer KI und Unternehmensdaten steckt.

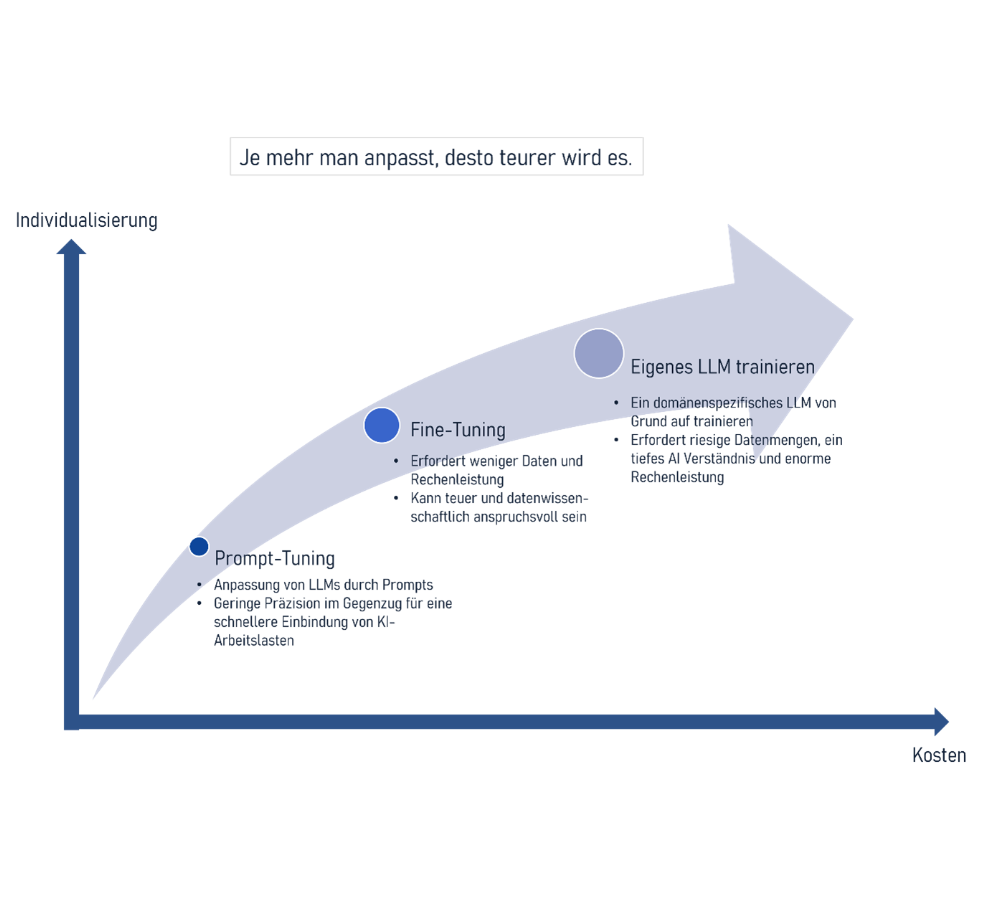

Die Implementierung von Generativer KI in Unternehmen birgt sowohl großes Potential als auch bedeutende Investitionen. Die genauen Kosten hängen stark von den individuellen Anforderungen, dem Umfang und der Zielsetzung ab.

Die Implementierung von LLMs kann auf verschiedene Weisen erfolgen. Hier sind drei primäre Ansätze:

- LLMs von Grund auf trainieren (am teuersten

- Fine-Tuning eines bestehenden LLMs (individuell abhängige Kosten): Dieser Ansatz modifiziert vortrainierte Modelle durch zusätzliches Training mit spezifischen Daten. Der große Vorteil hierbei ist die Effizienz: Es werden weniger Daten und Rechenleistung benötigt als beim Training eines Modells von Grund auf. Der Prozess beinhaltet die Anpassung spezifischer Parameter des vortrainierten Modells, wodurch es besser auf spezifische Aufgaben zugeschnitten ist.

- Prompt-Tuning eines bestehenden LLMs (geringe Kosten): Der kosteneffizienteste Ansatz. Hier wird ein vortrainiertes Modell durch gezielte Eingabeaufforderungen (Prompts) genutzt. Obwohl diese Methode in der Umsetzung einfach und kostengünstig ist, bietet sie langfristig gesehen möglicherweise weniger Mehrwert, da das Modell nicht speziell für firmenspezifische Aufgaben optimiert wird.

Für größere Unternehmen oder solche, die besonderen Wert auf umfassende Datenanalysen, hohe Sicherheitsstandards und den Schutz von geistigem Eigentum legen, sind maßgeschneiderte Lösungen oft unerlässlich. Dies kann bedeuten, dass sie in lizenzierte, anpassbare Modelle investieren und mit spezialisierten Anbietern und Partnern zusammenarbeiten. Hier können die Kosten in den Millionenbereich gehen.

Die Allgemeinkosten gliedern sich somit im Wesentlichen unter in:

- Inferenzkosten: Kosten, die anfallen, wenn ein LLM aufgerufen wird, um Antworten zu generieren.

- Tuning-Kosten: Kosten für die Anpassung eines LLMs an spezifische Anforderungen.

- Pre-Training-Kosten: Investitionen, die notwendig sind, um ein LLM von Grund auf neu zu trainieren.

- Hosting-Kosten: Dies sind die Kosten für die Bereitstellung und Wartung eines LLMs, vor allem wenn es über eine API zugänglich gemacht wird.

Generative KI hat sich in der Technologiebranche rasch als heiß diskutiertes Thema etabliert. Die Vorhersagen sind vielversprechend und weisen auf enorme Fortschritte und Innovationen in diesem Bereich hin. Es wird prognostiziert, dass Unternehmen, die frühzeitig in generative KI investieren und sie richtig implementieren, im Wettbewerb deutlich im Vorteil sein werden.

Strategische Bedeutung für Unternehmen:

Unternehmen müssen strategisch die generative KI betrachten, um deren Einfluss auf Geschäftsmodell und Wettbewerbsfähigkeit zu erkennen. Ein zeitlich unpassender Einstieg kann nachteilig sein. Dabei ist auch zu beachten, welche Folgen KI für die Mitarbeiter hat.

Ethik und Regulierung:

KI bietet Vorteile, bringt aber neue ethische Herausforderungen auch im Bereich Datenschutz und Sicherheit mit sich. Unternehmen müssen das Konzept der „Responsible Artificial Intelligence“ beachten und sich an Regulierungen wie den „AI Act“ halten. Es ist zudem entscheidend, Urheber- und Verwertungsrechte bei der KI-Implementierung zu klären, um geistiges Eigentum zu schützen und rechtliche Probleme zu vermeiden.

Bildung und Bewusstsein:

Für eine erfolgreiche Implementierung von KI ist es entscheidend, dass sowohl Führungskräfte als auch Mitarbeiter über Grundkenntnisse in diesem Bereich verfügen. Ein umfassendes Verständnis dafür, wie KI funktioniert, welche Daten sie benötigt und wie sie sicher und ethisch korrekt eingesetzt werden kann, ist von zentraler Bedeutung.

Liongate ist Ihr Partner bei der erfolgreichen und nachhaltigen Einführung von KI für ihre Kundeninteraktion:

- Wir beraten sie bei der Identifizierung und Ausarbeitung von relevanten Anwendungsfällen.

- Wir entwickeln mit ihnen erste AI Prototypen und evaluieren mit ihnen die Erschließung von Generativer AI für Ihre Kundeninteraktion

- Wir bauen und betreiben für sie innovative und sichere Cloud-Lösungen für die Kundeninteraktion. Hierbei nutzen wir als AWS- und Salesforce-Partner die innovativsten Plattformen.

Holen Sie sich erste Antworten.

Nutzen Sie unser kostenloses Analysegespräch.

Tauschen Sie sich unverbindlich mit einem unserer Berater aus. Im persönlichen Gespräch können Sie Ihre Fragen klären. Sie erhalten Empfehlungen für nächste sinnvolle Schritte und besprechen, wie die Roadmap bei einer Zusammenarbeit aussehen kann.