Das Potenzial von Generativer KI

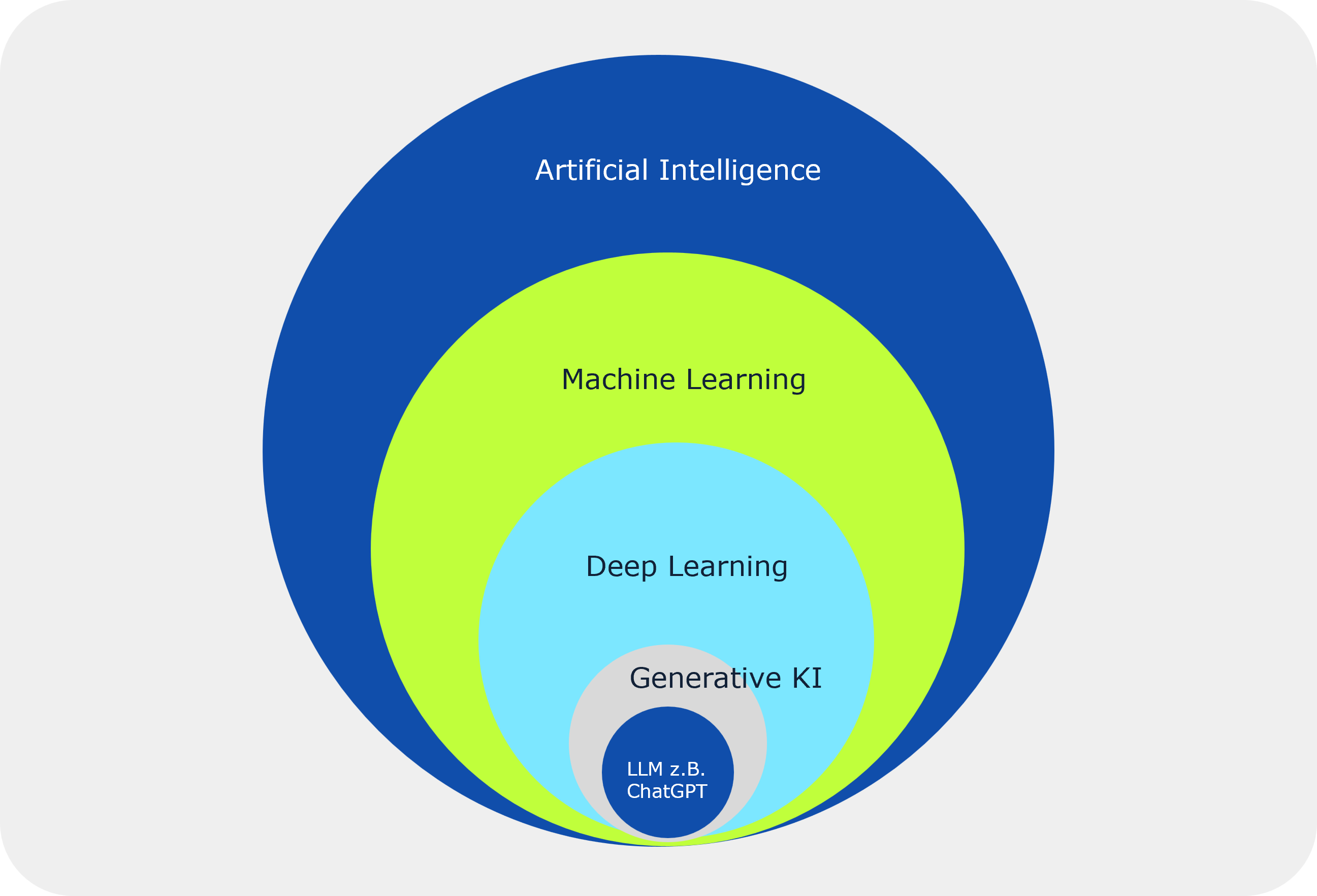

Generative KI (englisch Generative AI) ist eine Form der künstlichen Intelligenz, die mit sehr großen Datenmengen trainiert wurde, um Inhalte wie Texte, Bilder, Musik und neuerdings sogar Videos zu erstellen. Das folgende Bild veranschaulicht die begriffliche Einordnung in die verschiedenen Bereiche und Disziplinen der KI.

Sehr vereinfacht dargestellt nutzt das trainierte Modell beim Generieren von Inhalten Wahrscheinlichkeiten, um sequenziell Entscheidungen zu treffen, welches Wort oder Element als nächstes kommt, basierend auf dem bisher generierten Kontext.

Fast jeder wird den Satz „Alle meine Entchen..“ mit „schwimmen auf dem See“ vervollständigen, da dies die höchste Wahrscheinlichkeit hat. Genauso macht es die Generative KI und bietet so neue, ungeahnte und faszinierende Möglichkeiten Vorhersagen zu treffen, Inhalte zu kreieren und Dialoge mit Kunden zu automatisieren.

So wird es immer schwieriger in der Kommunikation zwischen Mensch und Maschine zu unterscheiden und die aktuelle KI dürfte den bereits 1950 definierten Turing Test bestehen (Wie weit dieser Test noch relevant und sinnvoll ist, wäre einen extra Artikel wert).

Unternehmen verknüpfen mit den neuen Möglichkeiten immense Erwartungen. IWConsult schätzt den Beitrag zur Bruttowertschöpfung in Deutschland auf Potenzial von 320 Mrd. €.

KI ist somit eine Top Prio für alle CEOs in Deutschland. Ernüchternd ist, dass bisher aber nur 17% der deutschen Unternehmen KI einsetzen und vermutlich davon auch nur eine geringe Anzahl der Use Cases einen sinnvollen Unternehmensbeitrag leisten.

Doch, was sind die Ursachen für diesen „KI Gap“ und wie können Unternehmen das Potential gewinnbringend und sicher beheben? Hier lohnt sich ein Blick auf verbreitete Hürden in Unternehmen.

Der KI Gap – Hürden bei der Einführung und Anwendung

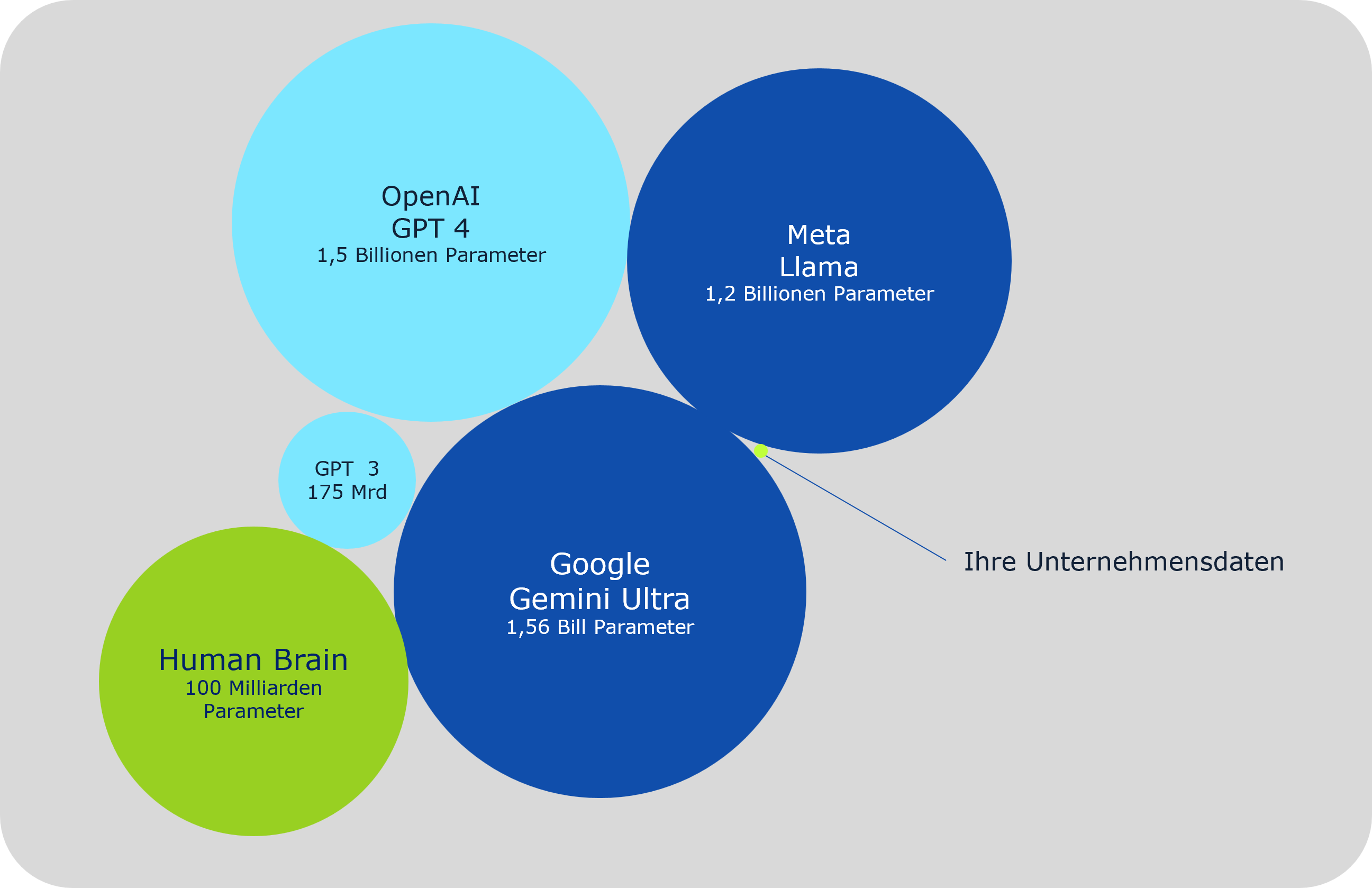

Die Grundlage von Generativer KI sind LLM (Large-Language-Modells) die mit sehr großen (frei verfügbaren) Datenquellen trainiert wurden. Das bekannteste LLM ist sicherlich GPT-4 von OpenAI. Die LLMs beinhalten aber (hoffentlich 😉) nicht ihre sensiblen Unternehmensdaten und so hat sicherlich jeder schon mal Chat-GPT um Hilfe gefragt, aber das schafft noch keinen Mehrwert im Unternehmenskontext. Die zweite Herausforderung in diesem Kontext ist wie Generative KI mit aktuellen und relevanten Unternehmensdaten umgeht. Generative KI wird immer nur bis zu einem definierten Stichtag trainiert und hat somit auch kein Wissen über aktuelle Ereignisse.

KI und Compliance

Die EU hat gerade erst mit dem AI Act (https://artificialintelligenceact.eu/de/) einen ersten regulatorischen Rahmen zum Umgang mit KI verabschiedet. Für Unternehmen ergeben sich daraus für den Einsatz von KI unter anderem die folgenden Fragen:

- Wie stellen wir sicher, dass keine personenbezogenen Daten weitergegeben werden (und ggf. auch nur in der EU verarbeitet werden)?

- Wie gewährleisten wir vollständige Transparenz über die für die Antwort referenzierten Quellen?

- Wie stellen wir sicher, dass unsere Mitarbeiter nur autorisierten Zugriff auf relevante Inhalte erhalten?

- Ist eine DSGVO konforme Verarbeitung der Daten gewährleistet (Datensparsamkeit, Recht auf Vergessen…)?

- Werden die eingegebenen Daten gegebenenfalls als Trainingsdaten für die KI weiterverwendet?

Wahrheit und Determinismus

KI hat mit dem Menschen eines gemeinsam: Sie macht Fehler. Ob sie beim Lernen aus Fehlern besser oder schlechter ist als der Mensch, wird sich zeigen. Ein gravierendes Problem sind sogenannte „Halluzinationen“, also schwerwiegende inhaltliche Fehler, die aber sprachlich sehr überzeugend dargeboten werden und deshalb oft unbemerkt bleiben.

Generierung von Bildern können Halluzinationen zu sehr kreativen und überraschenden Ergebnissen führen. Im Unternehmenseinsatz sind aber korrekte und deterministische Antworten elementar wichtig.

So wurde gerade im Unternehmenskontext ein Fall publik, in dem der Chatbot eines Autohändlers falsche Angaben zu Angeboten machte und zu allem Überfluss auch die Produkte der Konkurrenz empfahl. Hier wäre mehr menschliche Kontrolle sinnvoll gewesen.

Technische Hemmnisse

KI-Anwendungen verlangen spezifische leistungsfähige Infrastrukturen. Das spiegelt sich z.B. im Aktienkurs von Nvidia, dem führenden Lieferanten von GPUs, wieder.

Die Infrastruktur für ChatGPT kostet geschätzt 4 Mio USD pro Tag und das initiale Training von GPT-4 kostete ca 100 Mio USD. Lesenswert zu den Kosten von Generativer KI: ChatGPT and generative AI are booming, but the costs can be extraordinary.

Hier stellt sich die Frage, wie ein Unternehmen KI mit beherrschbaren Kosten nutzen kann? Bei Liongate setzen wir auf vorhandene Tools und LLMs, die mit vergleichsweise geringem Aufwand für den Einsatz in Ihrem Unternehmen angepasst werden können.

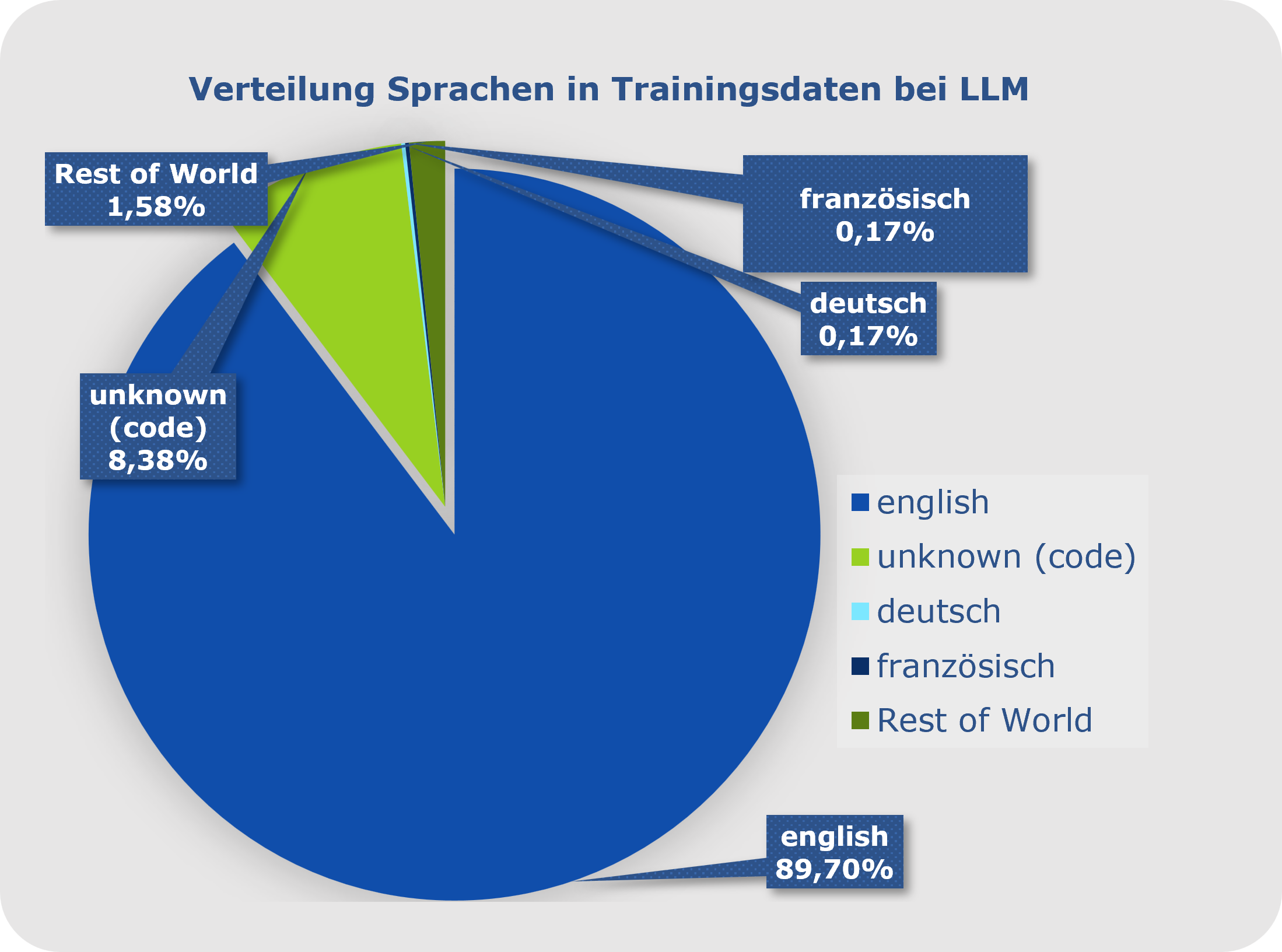

Unterstützung Deutscher Sprache in LLMs

Die bekannten und verbreiteten LLMs werden (derzeit) von amerikanischen Unternehmen entwickelt und betrieben. Das Training erfolgt zum großen Teil (siehe Bild unten) mit englischsprachigen Texten (ca 90%) und deutsche Texte sind nur mit 0,17% Anteil an den Trainingsdaten. Für kleinere Länder oder Sprachen ist das natürlich ein noch größeres Problem und hat auch einen sozio-kulturellen Aspekt.

Für deutschsprachige Unternehmen bzw Unternehmen mit deutschsprachiger Zielgruppe stellt sich die Frage wie eine hochwertige Sprachverarbeitung in deutscher Sprache möglich ist?

Volatilität der technologischen Entwicklung

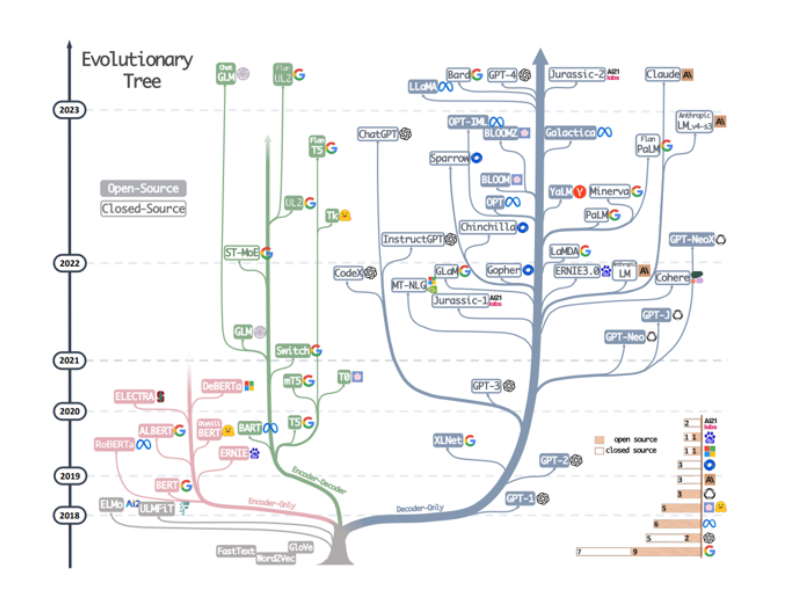

Wie bereits erwähnt ist GPT-4 derzeit Marktführer. Aber allein in 2023 sind 29 LLMs entstanden, die alle für unterschiedliche Einsatzzwecke und Zielgruppen ihre Berechtigung haben. 22 dieser LLMs sind erfreulicherweise Open Source.

Ein Ende der Entwicklung ist hier noch nicht absehbar und laufend entstehen neue Innovationen. Für Unternehmen stellt sich die Frage, wie man bei dieser Volatilität Schritt halten und sinnvolle und nachhaltige Investitionen tätigen kann?

Generative KI mit Liongate

Das Liongate Gen KI Framework

Die bisherigen Ausführungen zeigen reichlich Hürden und Fragen auf dem Weg zum Einsatz von Generativer KI in Unternehmen – Zeit für Antworten und Lösungen.

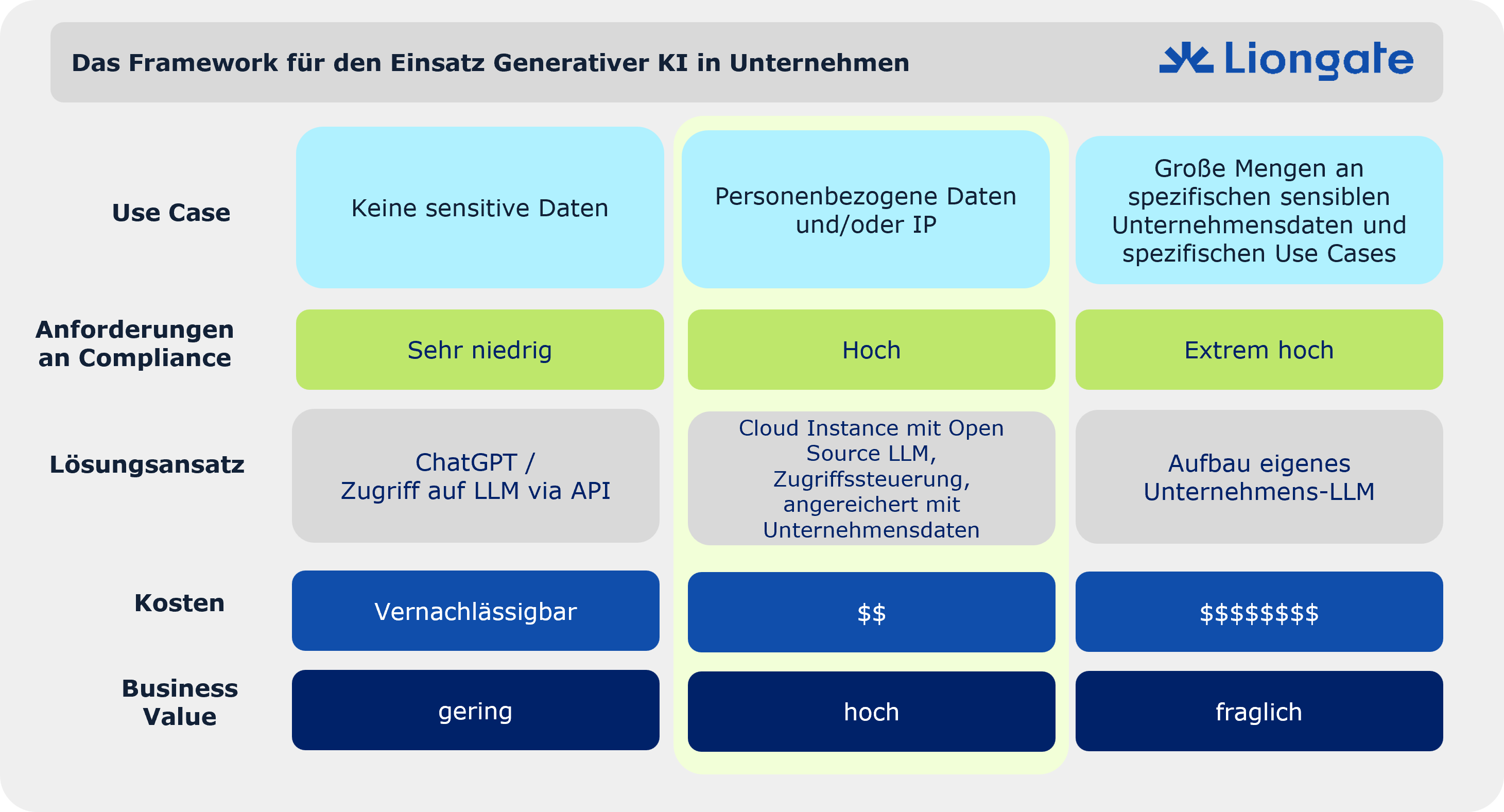

Die folgende Abbildung zeigt unser Framework für den Einsatz Generativer KI in Unternehmen. In der linken Spalte nutzen Anwender einfach den Prompt von Chat-GPT oder anderen LLMs oder der Zugriff erfolgt über deren bereitgestellte APIs. Dies hat jeder schon mal probiert, hat eine minimale Einstiegshürde und auch vernachlässigbare Kosten. Allerdings lassen sich hiermit keine sensitiven und unternehmensrelevante Daten verarbeiten und somit ist der Business Value eher gering. Als Alternative bietet sich die Entwicklung eines eigenen LLMs mit spezifischem Domain-Knowhow an. Die Kosten hierfür sind aber extrem und es gibt nur wenige Unternehmen, die sich das leisten können und wollen. Ein Beispiel ist Bloomberg, die mit immensem finanziellem Aufwand ein LLM mit all ihren Finanzdaten erstellt haben (siehe). Das Kosten-Nutzen-Verhältnis ist hier aber mehr als fraglich.

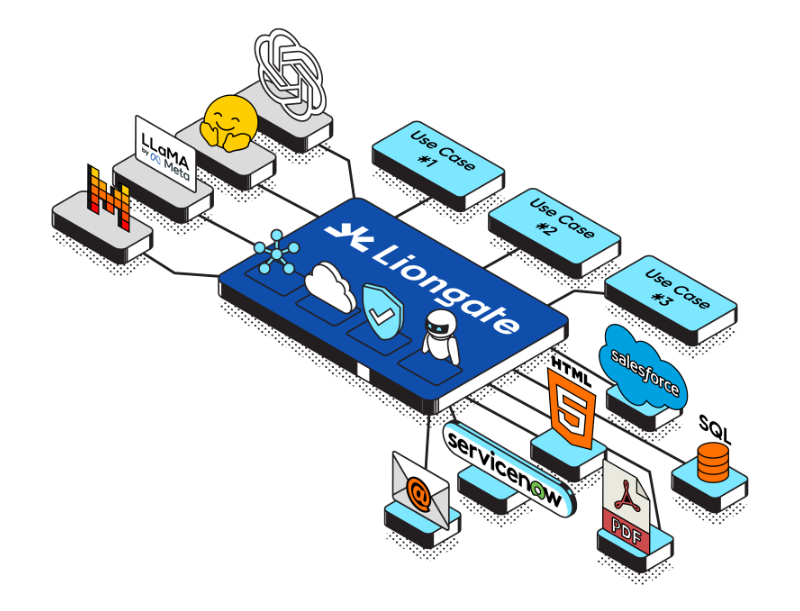

Die sinnvollste Variante und unser Ansatz ist es intelligent ein vorhandenes LLM mit Unternehmensdaten anzureichern. Dies ist in der mittleren Spalte dargestellt und wird im folgenden weiter ausgeführt. Aus Compliance-Sicht ist es sinnvoll hier auf Open Source LLMs mit gleicher Performance wie Chat-GPT zu setzen und dieses Open Source LLM sicher in einer dedizierten Cloud-Umgebung zu deployen

Der Liongate AI Stack für sichere und innovative Unternehmens Use Cases mit Generativer KI

Fazit: Wirtschaftlicher Einstieg mit vorhandenen LLMs

In der Praxis müssen Unternehmen eine Reihe von Herausforderungen meistern, um Generative KI gewinnbringend und sicher einsetzen zu können. In den meisten Fällen empfiehlt sich der goldene Mittelweg zwischen ChatGPT, das kostengünstig aber für den Einsatz im Unternehmen ungeeignet ist, und von Grund auf selbst entwickelten Large Language Models, die zwar sicher aber unbezahlbar sind. Bei Liongate setzen wir auf sichere und mit geringem Aufwand anpassbare Open-Source-Lösungen in der Cloud.